| 类型 | 说明 |

|---|---|

| 论文信息 | Multi-Institutional Deep Learning Modeling Without Sharing Patient Data: A Feasibility Study on Brain Tumor Segmentation Micah J Sheller, G Anthony Reina1, Brandon Edwards, Jason Martin, and Spyridon Bakas |

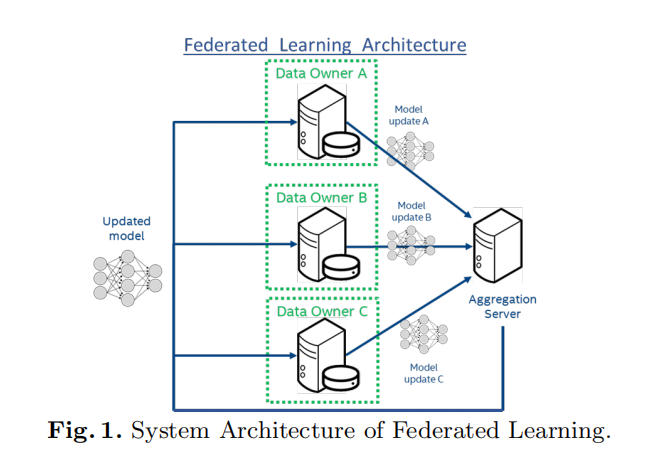

| 解决的问题 | 隐私保护下非数据共享的分布式深度学习系统 |

| 系统结构 |  |

| 方法名称 | Federated Learning (FL) |

| 方法说明 | 1.owner不用分享数据,仅仅本地训练得到model,进而将得到的modell更新给中心服务器 2.中心服务器将各站点上传的更新权重取平均进行聚合 3.中心服务器分发聚合更新后的权重给各个站点 |

| 超参数 | 1.每轮训练的周期(Epochs per round, EpR) 2.每轮训练的参与者数量 3.模型更新压缩/剪枝方法 |

| 对比现在方法 | 1.Cyclic Institutional Incremental Learning (CIIL) 2.Institutional Incremental Learning (IIL) |

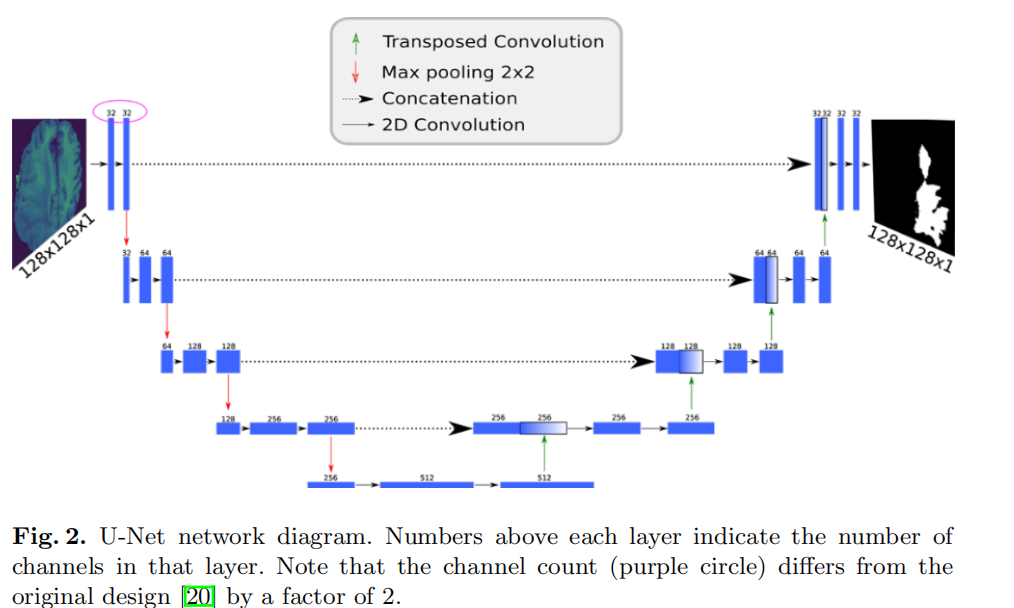

| Model | U-Net |

| 数据 | BraTS多模态数据,取FLAIR单模态训练 |

| 实验 | 单站点Data-sharing分布,模拟多站点分布,现实的BraTs分布 |

| 1 | BraTs分布上的实验结果 |

| 2 | 基准测试–Dice Coefficient:$DC=\frac{2\mid P\bigcap T\mid}{\mid P\mid+\mid T\mid}$, P为预测值,T为真实标签 |

| 3 | $loss=log(\mid P\mid+\mid T\mid+1)-log(2\mid P\bigcap T\mid+1)$ |

| 4 | 4-32模型站点分布实验 |

| 5 | 基础U-Net实验 |

| 6 | 单站点CIIL灾难性遗忘实验 |

| 参数设置 | batchsize=64, learning rate=5e-4, Adam Optimizer |

| 未来工作 | 1.不同站的不同的私有机器学习模型 2.不同批量、学习率、优化算法的实验 3.异源数据实验 4.训练过程中,某些站点接入/移出实验 5.语义分割的差异性隐私训练研究 |

| 结论 | 1.达到了基于数据分享的集中式性能的99%,甚至在分布不平衡的数据上 2.CIIL存在灾难性遗忘问题,且完整的验证必须在每次循环后进行,同步和聚合的花销比FL大 3.CIIL和IIL不能很好地应用于多站点,而FL在多站点上保持了其优秀性能 |

| 疑问与思考 | 1.没有对比不同参数更新聚合方法–文中解释说不同方法对比通常只是用于缓解与医学领域不相关的参与者限制(What???) 2.没有对比多个模型 3.没有对比多种数据集 |

数据集修改

1 | import nibabel as nib |